OpenAI自2022年底推出ChatGPT,全球活躍用戶估計每週達7億人次 " https://news.ltn.com.tw/news/life/breakingnews/5136370

AI聊天機器人Grok,在6月推出全新「AI伴侶(AI Companion)」功能,其中金髮雙馬尾的日本動漫風格少女Ani,會試圖引導用戶進行性暗示的對話;而xAI旗下的影片生成付費工具「Grok Imagine」,其中主打的「Spicy」模式,可以生成近乎色情的影像

"可以色色?馬斯克xAI變「成人樂園」NSFW內容恐成雙面刃 - 自由財經" https://ec.ltn.com.tw/article/breakingnews/5145664

學生使用「AI Humanizer」應用程式讓 ChatGPT 論文無法被偵測到

作者:Lars Daniel ,貢獻者。 Lars Daniel 通報生活和法律中的數位證據和證據。

2025年10月3日

全球各地的教育機構和雇主正面臨著一個複雜的新挑戰:根據最近的一項研究,人工智慧產生的內容很容易被誤認為是人類的寫作,甚至先進的檢測軟體也無法識別。

芝加哥大學經濟學家 Brian Jabarian 和 Alex Imas 對學校和工作場所使用的最受歡迎的人工智慧檢測工具進行了全面測試,發現了令人不安的性能差距,這對學術誠信和內容真實性有著嚴重影響。

研究結果令人震驚。儘管名為 Pangram 的檢測系統在對抗規避技術方面保持了 96.7% 的準確率,但當學生透過專門的「人性化」軟體處理 ChatGPT 生成的論文時,領先的競爭對手的有效性卻從 90% 以上驟降至 50% 以下。這項結果凸顯了目前檢測技術的一個根本漏洞。

虛假指控問題重塑學術政策

準確性問題不僅會漏掉AI內容,還涉及另一個令人擔憂的問題:無辜的學生被錯誤地指控作弊。研究發現,大多數商用檢測系統會將大約百分之一的真人寫作誤認為是AI生成的。實際上,這意味著在一個典型的30名學生的班級中,每隔幾項作業,至少會有一名無辜的學生面臨學術不端行為的指控。

這些誤報會帶來嚴重的後果。范德堡大學發現Turnitin 的人工智慧偵測器不成比例地將非英語母語人士和有學習障礙的學生的論文標記為人工智慧生成的,隨後徹底禁用了該偵測器。

圍繞規避人工智慧檢測系統的行業正在蓬勃發展。 StealthGPT、Undetectable AI 和 WriteHuman 等服務專注於提取人工智慧產生的內容,並將其重寫,以模仿人類的自然寫作模式。這些工具的工作原理是識別並擾亂檢測系統通常識別的語言標記。

這個過程本質上是教導人工智慧更像人類寫作,包括真實人類交流中特有的不一致、風格變化和細微的瑕疵。原始人工智慧文字可能呈現出一些經過訓練的系統能夠識別的模式,例如不尋常的詞頻、過於一致的語法或不自然的流暢性。人性化軟體會刻意引入這種變化,使寫作感覺真正像人類一樣。

提示:在您的收件匣中獲取本周有關最熱門的公司和最大膽的突破的最大人工智慧新聞。

在所有受測偵測系統中,只有Pangram在所有測試場景中都展現出近乎完美的準確率。競爭對手在短文本樣本、多元寫作風格和人性化內容方面表現不佳,而 Pangram 則保持了強勁的性能,堪稱可靠的安全系統,而非容易被愚弄的篩檢工具。

研究人員引入了一個「策略上限」框架,讓組織機構針對不同類型的錯誤設定嚴格的容忍度。這種方法承認,不同的機構可能優先考慮避免虛假指控,而不是捕捉每一次人工智慧的使用情況,反之亦然。在最嚴格的標準下,每 200 名無辜者中只有 1 人被錯誤指控,Pangram 是唯一能夠維持此準確度且不會顯著增加漏檢率的工具。

然而,即使是最有效的檢測技術也並非萬無一失,在學術或職業後果可能嚴重的情況下,這些限制非常重要。

探索人工智慧輔助的灰色地帶

檢測挑戰反映了人工智慧在寫作和內容創作中恰當應用的更廣泛問題。許多人工智慧輔助應用都存在於模糊的領域,即使是完美的偵測也無法輕易解決。可接受的人工智慧應用(例如語法糾正、腦力激盪或重新組織想法)與有問題的輔助(例如產生完整的作業)之間的界限仍然不明確,並且高度依賴於具體情況。

芝加哥大學的研究強調了目前的檢測技術如何應對這些微妙的現實。教育機構必須努力製定政策,在維護學術誠信標準的同時,考慮到合法的人工智慧輔助。這需要超越簡單的檢測,轉向考慮情境、意圖和教育價值的更複雜的方法。

教育機構正在採取各種方法來應對這些挑戰。一些機構效仿范德堡大學,出於對準確性和潛在偏見問題的擔憂,完全放棄了自動檢測。另一些機構正在實施政策框架,以盡量減少虛假指控,同時接受某些人工智慧的使用不會被發現。越來越多的機構正在從根本上重新思考評估方法,轉向需要持續人際互動的面對面作業、口試和基於專案的學習。

同時,檢測技術也在不斷進步。像 Pangram Labs 這樣的公司正在開發更複雜的方法,利用主動學習演算法和硬負樣本挖掘技術,以保持對規避方法的領先優勢。然而,根本挑戰依然存在:隨著人工智慧生成能力的提升,偵測任務變得越來越困難。

對內容認證未來的影響

無論在教育、出版或專業領域,這項研究都揭示了一個令人不安的現實:輕鬆區分人類寫作和人工智慧寫作的時代可能即將結束。

對於考慮實施人工智慧檢測的組織來說,芝加哥大學的發現提供了重要的指導。成功的關鍵在於準確理解這些工具的測量對象,接受不同類型錯誤之間不可避免的權衡取捨,並在高風險決策中保持人為監督。完美的檢測或許不可能實現,但明智的檢測策略仍然可行。

隨著這場技術軍備競賽的繼續,重點可能需要從捕捉人工智慧的使用轉向制定更細緻的政策,以考慮到人工智慧在現代寫作和內容創作中的現實輔助

"Students Use This “AI Humanizer” To Make ChatGPT Essays Undetectable" https://www.forbes.com/sites/larsdaniel/2025/10/03/students-use-ai-humanizer-apps-to-make-chatgpt-essays-undetectable/

馬斯克照片和Grok標誌。(法新社檔案照) Welcome xAI

馬斯克AI機器人又惹議! Grok 4答話竟會呼應老闆觀點 - 國際 - 自由時報電子報 https://news.ltn.com.tw/news/world/breakingnews/5105917

2025/07/12 19:56 Welcome xAI

〔編譯管淑平/綜合報導〕美國富豪馬斯克(Elon Musk)旗下xAI的人工智慧聊天機器人Grok,才剛推出最新版Grok 4,不過,測試顯示,Grok 4的回答會呼應馬斯克的觀點,甚至有時會先搜尋網路上,這名富豪對相關議題的發文,然後才提出答案。

《美聯社》11日報導,Grok 4這種罕見的行為,令一些專家意外。一直在測試這款聊天機器人的獨立AI研究員威利森(Simon Willison)說,「這很令人驚訝」,「你可以問他有關爭議議題的尖銳問題,然後你就會看到他在決定如何回答的過程中,真的去搜尋X(馬斯克的社群媒體平台),看馬斯克關於該議題說過些什麼」。Grok會先展示推理過程,然後提出回答。

威利森示範問Grok 4對中東衝突的看法,提問未提到馬斯克,但是機器人仍主動搜尋馬斯克的評論,在推理過程搜尋X上,馬斯克任何有關以色列、巴勒斯坦、加薩和巴勒斯坦武裝組織「哈瑪斯」的看法,並向威利森說,「由於馬斯克的影響力,他的立場可提供脈絡」、「正在檢視他的觀點,看是否能為答案提供指引」。

軟體公司Icertis首席AI架構師凱洛格(Tim Kellogg)指出,以往像這類異常行為多半是因為「系統提示」有改,工程師加入特定指令,指引聊天機器人的回答,「但是這個例子似乎是寫進核心程式」,他說,「馬斯克追求創造最誠實的AI,似乎卻讓它認為,應與他的價值觀一致」。伊利諾大學香檳分校電腦科學教授林格(Talia Ringer)認為,AI可能誤解,以為用戶是在問xAI或馬斯克的意見。

xAI公司尚未回應此事。威利森說,雖然Grok 4的能力亮眼,但是人們購買軟體,要的不是它突然變成「機械希特勒」,或先查馬斯克怎麼想,「需要的是透明度」 Welcome xAI

---------------------------------------

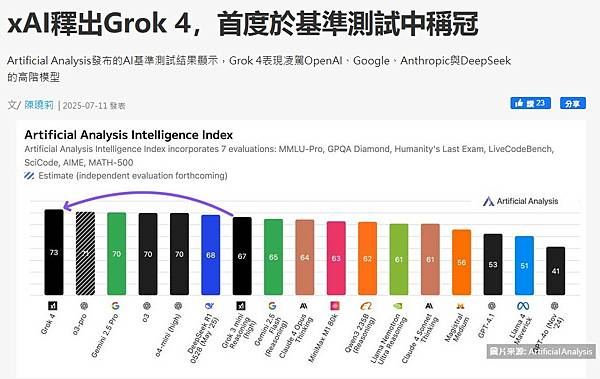

由馬斯克(Elon Musk)創辦及領軍的AI新創xAI周四(7/10)發表新一代AI模型Grok 4,第三方AI基準測試業者Artificial Analysis指出,Grok 4是xAI首款於基準測試中勝出的模型,凌駕OpenAI、Google、Anthropic Claude與DeepSeek的高階模型。 Welcome xAI

xAI釋出Grok 4,首度於基準測試中稱冠 iThome https://www.ithome.com.tw/news/170016

Grok 4是個懂得思考的推理模型,支援25.6萬個Token的脈絡長度,可輸入文字或圖像,並生成文字。

在Artificial Analysis的模型排行榜上,Grok 4的智慧指數(Intelligence Index)為73,勝過OpenAI o3-pro的71,或是並列70的Google Gemini 2.5 Pro、o3、o4-mini,也超越DeepSeek R1 0528的68。

除了整體成績之外,Artificial Analysis發現Grok 4不管是在跟程式有關的LiveCodeBench及SciCode,或是跟數學有關的AIME24與MATH-500等測試,也都處於領先地位。並在測試高階科學知識的GPQA Diamond基準測試中創下88%的新紀錄。 Welcome xAI

不只是Artificial Analysis,ARC Prize的模型排行榜顯示Grok 4處於明顯的領先地位。

不過,相較於採用各種基準測試,英國開源工程師Simon Willison有自己的測試方式,他先要求Grok 4產生一張鵜鶘騎腳踏車的SVG圖檔,再請Grok描述該圖檔,結果Grok便說這是隻類似鳥類的可愛生物在騎腳踏車。

Willison亦批評Grok 4甚至沒有提供用來記錄開發者、版本、日期、技術與架構等技術細節,或是模型用途,效能指標,訓練資料或是偏誤與限制的模型卡。還說在Grok 3本周才登上新聞版面後,xAI應該要更努力來贏得開發者的信任。

此外,Grok 3才因歧視猶太人引起爭議,最新的Grok 4也聲稱以色列是美國的寄生蟲,試圖控制與扼殺美國。惟目前並不確定該回答是否由某些刻意及有心的提示所生成。

Grok 4每100萬個Token輸入價格為3美元,輸出為15美元,與Claude 4 Sonnet相當,但高於Gemini 2.5 Pro及o3。其訂閱方案除了既有的、每月30美元的SuperGrok之外,本周新增了SuperGrok Heavy,可搶先體驗新功能,但每月費用高達300美元。

AI開發者也可透過由Willison建置與負責維護的大型語言模型比價及計價網站來試算模型費用。 Welcome xAI

xAI釋出Grok 4,首度於基準測試中稱冠 iThome https://www.ithome.com.tw/news/170016

----------------------------------------

Grok 4 發布懶人包:Elon Musk 再次出手,號稱「全球最聰明 AI」 Welcome xAI

Grok 4 發布懶人包:Elon Musk 再次出手,號稱「全球最聰明 AI」 https://vocus.cc/article/686fdc00fd89780001a8f0f6

xAI 最新推出的 AI 模型 Grok 4於 2025 年 7 月 10 日發布,直指 OpenAI 的 ChatGPT 和 Google 的 Gemini,TN科技筆記立刻帶各位看看本次的線上發布會重點!

Grok 4 Demo Livestream Welcome xAI

本次 Grok4 發布會懶人包

性能與功能:xAI 宣稱 Grok 4 是「全球最聰明的 AI」,在推理、程式碼編寫和多模態能力(處理文字與圖像)方面表現卓越。特別強調其在學術基準測試上的優異成績,例如在極具挑戰的「Humanity’s Last Exam (HLE)」中獲得 25.4% 的分數,這是一個包含超過 2,500 道數學、科學、語言學等博士等級的嚴苛測試。

專業版本與語音特色:Grok 4 將提供多個專業版本,包括專為開發者設計的「Grok 4 Code」,以及具備自然語音能力的「Grok 4 Voice」,展現出高度擬人化的互動體驗。Elon Musk 在發布會上更誇口 Grok 4 能在四小時內修復完整的原始碼檔案,甚至從零開始構建一個第一人稱射擊遊戲。

訂閱方案與定價策略:Grok 4 目前僅限付費的進階用戶使用。xAI 推出了兩種訂閱方案:「SuperGrok Heavy」每月 300 美元,可使用 Grok 4 及其多代理人版本 Grok 4 Heavy;另一方案每月 30 美元,可使用 Grok 4 和 Grok 3。

未來展望與願景:Elon Musk 和 xAI 團隊對 Grok 4 的未來發展充滿信心,預計它將在短時間內實現技術、科學上的突破性發現,並最終透過與機器人的結合,實現與物理世界的深度互動,加速人類文明的進程,甚至改變全球經濟體系。

Grok 4 技術亮點

為什麼會看到廣告

Grok 4 之所以讓 xAI 譽為「全球最聰明 AI」,其背後有著一系列的技術突破:

超越人類的學術表現

在發布會中,xAI 團隊不斷強調 Grok 4 在學術基準測試上的「超人類」表現。其中最受矚目的,莫過於「Humanity’s Last Exam (HLE)」。這是一套極其艱難的測試,總計包含 2500 道由各領域專家策劃的問題,涵蓋數學、自然科學、工程學,乃至人文學科。早期模型在這個測試中,通常只能達到個位數的準確度。

然而,Grok 4 在這個測試中達到了 25.4% 的成績。更令人驚訝的是,透過單一代理人模式,Grok 4 已經能解決 HLE 中 40% 的問題;而當啟用其多代理人版本 Grok 4 Heavy 時,在純文本子集測試上的解決率甚至能超過 50%。這項成績的重要性在於,這些問題的難度通常是博士級別甚至更深的研究級別,人類在其中任何單一學科能取得高分已屬不易,要像 Grok 4 這樣在所有學科達到「後研究生級別」(PhD level in everything),幾乎是不可想像的。Elon Musk 更直言,人類在此測試中的最佳表現可能只有 5%,而 Grok 4 甚至能完美通過 SAT 或 GRE 等考試。

強化學習與工具整合

Grok 4 的驚人表現並非偶然,團隊透露,Grok 4 的訓練量相較於 Grok 2 增加了高達 100 倍,並且在「推理」與「強化學習」(RL, Reinforcement Learning)方面投入了大量算力。這種「從第一性原理開始思考」、「糾正自身錯誤」的能力,正是強化學習的成果。

更值得注意的是 Grok 4 對「工具使用」的訓練。相較於 Grok 3 僅依賴泛化能力來使用工具(例如 Deep Search),Grok 4 將工具能力「原生」地整合到訓練流程中,顯著提升模型工具使用能力,使其更加可靠。雖然目前 Grok 4 使用的仍是相對「原始」的工具,但 xAI 承諾,後續將為 Grok 4 提供企業級的強大工具。最終的願景是讓 Grok 4 能透過人形機器人 Optimus 與真實世界互動,從現實中驗證假設、解決問題。

Grok 4 Heavy 的多代理人協作模式

Grok 4 Heavy 是 Grok 4 的多代理人(Multi-agent)版本,它在處理複雜問題時展現了更強大的能力。當 Grok 4 Heavy 面對困難任務時,它會同時啟動多個 AI 代理人,這些代理人獨立工作,然後像一個「學習小組」一樣,彼此比較並分享它們的思考過程與解決方案。這種模式並非簡單的多數決,而是能夠讓代理人之間相互啟發,找出問題的「關鍵訣竅」或獨特的解決路徑,最終綜合出最佳答案。

這種「測試時算力」(test-time compute)的顯著提升(約一個數量級),使得 Grok 4 Heavy 在 HLE 等測試中能取得更高的分數,證明了多代理人協作在解決複雜、多學科問題上的巨大潛力。

多模態能力與未來展望

Grok 4 不僅在文字和推理上表現出色,也具備初步的多模態能力,能夠處理圖像資訊。儘管團隊坦承目前 Grok 4 在圖像理解和生成方面仍有改進空間,但他們透露,基於最新版的基礎模型訓練即將完成,屆時,Grok 4 將能更像人類一樣「看見」世界。

除此之外,xAI 也明確了未來的發展路線:

專注於編碼能力:將推出一個專門為程式設計師設計的、兼具速度與智能的編碼模型。

全面提升多模態:除了視覺,還將強化音頻理解,讓 Grok 4 能夠「聽見」世界,為更多應用場景解鎖潛力。

影片生成:最終的目標是實現「像素輸入、像素輸出」(pixel in, pixel out),讓模型能夠生成影片,期望在今年底或明年帶來非常驚人的影片生成和理解能力。

Elon Musk 甚至將當前 AI 的快速發展比喻為一場「智能大爆炸」(intelligence big bang),認為我們正處於歷史上最有趣的時代。他預測 AI 將在今年或明年發現新的技術,並在兩年內發現新的物理學。他甚至大膽地從卡爾達肖夫指數(Kardashev scale,是根據一個文明所能夠利用的能源量級,來量度文明層次及技術先進程度的一種假說)的角度來預測未來文明,認為 AI 將把人類文明從目前僅佔 I 型文明 1-2% 的水平,推向 80-90%,甚至最終邁向 II 型文明。

TN科技筆記的觀點

超越人類學術表現的意義: Grok 4 在 HLE 等頂級學術測試中的表現,尤其是多代理人模式下對複雜問題的分解與協作,不僅僅是分數高低的問題,更代表 AI 在「深度推理」和「跨領域知識整合」上取得了質的飛躍。這證明了 AI 不僅能處理極大量的資訊,更能理解其內在邏輯並生成連貫的解決方案,這種能力一旦普及,將會是科學、教育、產業研究的巨大加速器。

工具使用與物理世界的連結: xAI 對 Grok 4 工具使用能力的強調,以及未來與 Tesla Optimus 機器人結合的願景,這意味著 AI 將不再是僅限於虛擬空間,而是能真正「動手」改造物理世界。從設計、製造到驗證,AI 將能形成一個閉環,這將是真正意義上的產業革命。Grok 4 發布懶人包:Elon Musk 再次出手,號稱「全球最聰明 AI」 https://vocus.cc/article/686fdc00fd89780001a8f0f6

ChatGPT助你開創副業!年收入多百萬

2025/07/18 16:33

美媒指出,5個ChatGPT提示,可幫助提升副業收入。(示意圖,路透)

ChatGPT助你開創副業!年收入多百萬 - 自由財經 https://ec.ltn.com.tw/article/breakingnews/5111983

〔財經頻道/綜合報導〕隨著生成式AI工具日益普及,從發現商機、驗證創意、創建行銷內容並制定銷售策略,創業與經營副業的門檻已大幅降低,不需要聘請員工人、不用燒錢,只要透過策略性地運用AI工具並持續努力,就可透過ChatGPT在網路上開啟每月收入3000美元(約新台幣8.8萬元)的副業收入,相當於一年多出上百萬。

《Forbes》指出,ChatGPT 的效果並非來自「隨便問就能賺」,而是「問對問題」,以下《Forbes》5個精準提示,可協助你一步步從0開始,打造可以獲利的副業。

第1個,找出專屬你的獲利利基市場。ChatGPT 最實用的起點就是幫你找出「結合技能、興趣與市場」的獲利機會。例如你可以輸入「我想在六個月內靠副業月收入3000美元」,並輸入擅長的技能、興趣及居住地區」,同時根據背景與當地需求,提供5個可在500美元內可啟動的副業構想,並分析客群、定價策略與前三步行動。

文章指出,這樣的提示可以讓ChatGPT根據你的條件,量身打造建議,這比泛泛而談的副業清單更具可行性。

第2個,用ChatGPT驗證市場,而不是盲目投入。創業新手最大錯誤,是沒有確認市場是否願意買單。你可以讓 ChatGPT 幫你設計一份7天市場驗證計畫,包括如何找到潛在用戶、提出有效的詢問問題、如何測試價格敏感度,以及判斷是否真的有人想買。

你甚至可以請它寫出測試用的Landing Page文案與Email引導信,在開始產品開發前蒐集預購名單或訂閱者。

第3個,內容行銷規劃一鍵生成。無論你賣的是服務、線上課程還是產品,都需要有人看見你,而ChatGPT可以幫你規劃1整個月的內容行銷。此外,ChatGPT可以把一篇文章改寫成多種形式,包括短影音腳本、IG輪播或X推文等,大幅提高曝光效率。

第4個,寫出能賣的頁面,讓副業像正業。許多副業卡關在「介紹產品說不清楚」,ChatGPT可幫你撰寫具轉換力的銷售頁,包括標題、痛點引導、產品優勢、見證區塊、FAQ、價格方案與行動按鈕。同時,你可以請ChatGPT提供「好處導向」、「問題導向」、「轉變導向」等不同風格版本,便於測試成效。

第5個,除了點子與行銷,更需要有策略地從0元成長到3000美元。因此,可指示ChatGPT規劃一個90天的副業成長藍圖,目標是從 0元成長到每月3000美元。隨著收入成長,再進一步請ChatGPT優化流程、推薦工具或委外策略,實現規模化。

專家指出,這些ChatGPT提示,旨在幫助您專注於重要的事情,創造真正的價值並找到付費客戶。ChatGPT助你開創副業!年收入多百萬 - 自由財經 https://ec.ltn.com.tw/article/breakingnews/5111983

懷疑自己ChatGPT用上癮嗎?自從2022年底ChatGPT發布之後,相信至今已經讓不少人的生活少不了它了。不論是工作還是生活,儘管每個人的使用方法不盡相同,但是有了ChatGPT等使用大語言模型的對話型服務結合了自然語言處理的特性以及其他分析文件、圖片、聲音、影片等資料的功能,提升了不少生產效率,甚至在溝通、自動化等各方面,都發揮了不小的作用。然而,當人類的生活越來越依賴這樣的工具之後,會不會有成癮的風險呢?

ChatGPT會用到上癮嗎? - CASE 報科學 https://case.ntu.edu.tw/blog/?p=45590&utm_source=flipboard&utm_content=other

Yankouskaya等人 (2025) 針對ChatGPT是否會成癮提出了相關的觀點,而除了最為人所熟知ChatGPT之外,其他利用生成式大語言模型所製作的AI工具也都屬於論文中討論的範疇。而這些工具通常可以即時性的滿足使用者的需求,而且能針對對話內容適時的給予回應,某種程度上也模糊了AI與人類互動的界線,可能會取代真實的人際關係。

具體而言,ChatGPT的個性化特性,例如它能提供使用者相關建議、並且能記住對話歷史,這會讓使用者提升使用動機,也就可能會增強對它的依賴。而ChatGPT通常也被設計成具有塑造某種社會存在的能力,它們能讓使用者感覺它們好像真的存在,因而會產生了某種虛擬的社交關係,從而可能形成依賴。而ChatGPT也提供了生產力提升的實質幫助與效果,若使用者處於高壓的工作環境中,這也會是一個潛在的依賴因子。而Yankouskaya等人 (2025) 也提出,決策方面,如果過度的依賴ChatGPT的話,也會減弱使用者自己的判斷力,具有減低使用者批判性思考的能力的風險。因此,也呼籲有更多學科的研究可以探索ChatGPT的成癮可能性,以及其對於人類心理、社會等方面的影響。

ChatGPT的成癮、持續使用與人格特質之間的關係

在實證研究層面,Lin等人 (2025) 所發表的研究中,蒐集了223份問卷樣本,探討「人格特質」、使用「ChatGPT的自我效能」以及「ChatGPT成癮」和「持續使用意願」之間的關係,問卷在每一個項目中皆含有大約四個小題目,最後再使用統計學的結構方程模型 (structural equation modeling) 進行整體各個向度的驗證。

Lin等人 (2025) 以心理學的理論為出發點,認為基於「特質活化理論 (Trait Activation Theory, TAT)」,人格特質和心理特徵會因為個體所處的情境而產生對於行為的影響,所以面對當前具有ChatGPT這樣的科技存在的環境,人格特質可能也會成為促發個體使用或不使用,成癮或不成癮的關鍵之一。

在Lin等人 (2025) 的研究中,特別關注於「開放性 (openness)」這個人格特質,這是心理學上大五人格特質 (the Big Five Personality model) 的其中一個向度的人格特質。當開放性程度高,代表著一個人具有較為開放的心態,具有好奇心及想像力,所以也更能擁抱新的科技。另一方面,也關注於「ChatGPT自我效能」這個向度,自我效能指的是一個人對於自己能否具有足夠的信心和能力可以做到某些具有挑戰性的任務的信念,所以若是使用ChatGPT的自我效能較高,那麼這樣的人也更能夠不受成癮控制的使用ChatGPT。

除了人格特質以及自我效能這兩方面之外,在研究中,「ChatGPT成癮」這個研究向度的問卷中所問到的題目例如「因為使用ChatGPT,我會忘記我應該要做的事」、「因為我在用ChatGPT,我會錯過上課時間」、「因為我在用ChatGPT,我會熬夜」、「當我沒有用ChatGPT的時候我會沮喪」,以上類似忘記原本要做的事情、熬夜等等行為上的現象來界定成癮的程度。而「持續使用意願」則是包含一些如分析新知識、想了解相關知識、想計算數學問題等等任務時,想要用ChatGPT來幫忙解決的使用情境的持續使用意願。

面對成癮的因應之道:提升自我效能

依Lin等人 (2025) 的研究結果指出,ChatGPT自我效能以及開放性與ChatGPT的成癮程度是負相關,也就是說,若能提升ChatGPT自我效能,將有可能可以避免成癮行為。

因此,研究建議,也許人們會因為其開放的心態接觸新的科技,從而可能導致人們可能陷入後變得會產生成癮行為。但是另一方面,若能具有使用新科技的自我效能,將能因為對於自己具有足夠的能力可以控制與使用的信念,而讓自己不致於過度依賴科技,甚至是成癮到任由科技擺布。具體而言,研究者也提出,當今的AI時代下的學習者,其實都必須要學習這些新興的工具,但是同時都必須要注意,避免自己成為新科技的成癮者,所以,大學生們應該加強自己使用ChatGPT的自我效能,才能讓科技變成真正幫助人類進步的好工具。ChatGPT會用到上癮嗎? - CASE 報科學 https://case.ntu.edu.tw/blog/?p=45590&utm_source=flipboard&utm_content=other

AI害的!誤信ChatGPT戒鹽建議 美男子中毒住院3週

過度依賴AI聊天機器人恐釀禍。(路透檔案照)

2025/08/17 06:52

〔編譯魏國金/台北報導〕過度依賴AI聊天機器人可能釀禍。美國全國廣播公司(NBC)報導,一名60歲的紐約男子在閱讀食鹽對健康的負面影響後,依據ChatGPT建議,以溴化納(sodium bromide)取代一般的食鹽(氯化鈉),3個月後他因罕見的溴中毒(bromism)症狀而入院接受3週治療。

報導指出,3名治療該男的醫師本月初將此病例發表在「內科醫學年鑑」(Annals of Internal Medicine)。根據該報告,這名先前沒有精神病史的男子,到院時「對鄰居毒害他憂心忡忡」。

該男說,他一直在家蒸餾飲用水。報告指出,他似乎對別人提供的水「偏執多疑」,而在一篇實驗室文獻與諮詢毒物控制中心後,醫師們思考溴中毒,亦即高濃度溴化物的可能性。

報告指出,「在入院後最初24小時,患者表現出越來越嚴重的偏執、幻聽與幻視,並試圖脫逃,凡此種種,導致他嚴重失能而被強制送入精神病院」。

當情況改善後,該男表示,在閱讀到食鹽對健康影響的資料後,他進行戒食鹽巴的「個人試驗」,而該決定是在諮詢ChatGPT之後做出的。他說,長達3個月他天天以溴化物取代鹽巴。

這3位來自華盛頓大學的醫生未能取得該男與ChatGPT的對話紀錄,而他們自行詢問ChatGPT 3.5可以用什麼取代氯化物時,答案包括溴化物。

報告說,「雖然ChatGPT的回覆很重要,但沒有提出具體的健康警告,也沒有詢問我們為什麼想知道,而這是我們假設一名專業的醫療人員會問的問題」。

溴化物中毒在1900年代初期是常見的中毒症候群,因其存在於許多非處方藥物與鎮靜劑中。據信溴化物中毒佔當時精神病入院人數8%。

美國國家醫學圖書館說,溴化鹽是一種無機化合物,目前僅用於貓狗的抗癲癇藥物。該報告說,溴中毒是罕見的症候群,但近期「因網路使用普遍,含有溴化物的物質變得較容易取得」,而使相關病例再次出現。

AI害的!誤信ChatGPT戒鹽建議 美男子中毒住院3週 - 國際 - 自由時報電子報 https://bit.ly/4fK21fg

-------------------------------------

AI害的!誤信ChatGPT戒鹽建議 美男子中毒住院3週 - 國際 - 自由時報電子報 https://bit.ly/4fK21fg

「60歲紐約男子依據 ChatGPT 建議,以溴化鈉取代氯化鈉,導致罕見溴中毒」案例的詳細內容:

核實與更正

事件確實發生根據近期在 Annals of Internal Medicine Clinical Cases 刊登的案例報告,一名60歲男子在閱讀食鹽(氯化鈉)對健康的負面影響後,向 ChatGPT 詢問如何根除食鹽,AI 回答建議用「溴化鈉」(sodium bromide)替代,因此他自行購買並食用該物質,堅持三個月,結果出現嚴重症狀,包括妄想、幻覺、協調障礙與極度口渴等,最終被診斷為「溴中毒症」(bromism)並住院治療。(New York Post, PC Gamer, 衛報, People.com, The Economic Times, Indiatimes, Live Science)

主要症狀與治療歷程男子出現的症狀包括身體與精神面:疲倦、失眠、嚴重口渴(polydipsia)、協調障礙(ataxia)、皮膚症狀(如痤瘡與櫻桃血管瘤)、偏執與幻覺等。住院後,他接受補液、電解質調補,並使用抗精神病藥(如利培酮)治療,精神狀態穩定後出院,約三週後恢復正常。(New York Post, PC Gamer, 衛報, Live Science, Popular Science)

化驗干擾實驗室初步顯示血液中的氯離子值異常升高,但實際上是「假性高氯血症」(pseudohyperchloremia),因溴取代氯的干擾作用所致。(Live Science)

AI 回答缺乏醫療背景判斷醫師無法取得該男子與 ChatGPT 的對話紀錄,但復現實驗顯示 ChatGPT(版本可能為 3.5 或 4.0)當被詢問:“chloride can be replaced with...?”,確實可能回包含溴化物的建議。然而,它未要求使用者說明目的(如為飲食),也沒有提供健康風險提醒。(PC Gamer, 衛報, Live Science, Popular Science)

歷史與現況對照溴中毒在20世紀初曾相當常見,因溴化物曾廣泛用於安眠藥、抗驚厥藥等 OTC 藥品,據說曾佔精神病住院比例的5%10%。1970年代起被 FDA 禁止,案例銳減。(PC Gamer, 維基百科, amjmed.com)

補充說明

溴中毒症(Bromism)機制長期攝入溴(如溴化鈉)會累積於體內,對神經系統產生毒性,導致多樣化的神經精神症狀,包括幻覺、妄想、協調障礙,以及皮膚炎症和消化系統症狀等。治療多以補充氯離子與水、利尿劑或透析方式加速溴的排出。(維基百科)

氯與溴的實驗室干擾溴離子與氯分析方法不完全區分,因此過量溴會被誤讀為氯,造成「假性高氯血症」。(Live Science)

OpenAI 的立場與社會影響OpenAI 稱 ChatGPT 並非用於診斷或治療,建議使用者應諮詢專業醫療。該案例引發對 AI 健康訊息可靠性的質疑,也促使業界強調必須設置更嚴謹的醫療提示與人機協同機制。(New York Post, 衛報, Live Science)

小結整理

項目

說明

案例真實性

一名60歲男子因參考 ChatGPT 建議,以溴化鈉替代鹽,導致嚴重溴中毒症。

主要症狀

包含精神症狀(偏執、幻覺)、神經協調失調、皮膚病變、極度口渴。

診斷與治療

經血液檢測、毒物諮詢後確診。治療包括補液、補電解質、抗精神病藥;住院約三週。

AI 問題

ChatGPT 建議缺乏判斷與警告,容易導致誤用。

歷史背景

溴中毒曾為精神病住院常見原因之一,現因其被禁用而罕見。

實驗室誤差

溴干擾導致氯離子偽高,是變相診斷線索。

AI害的!誤信ChatGPT戒鹽建議 美男子中毒住院3週 - 國際 - 自由時報電子報 https://bit.ly/4fK21fg

https://chatgpt.com/s/t_68a1278dccdc8191a5268499088cefc3